Apple только что обыграла Nvidia в собственной игре SLI с M1 Ultra?

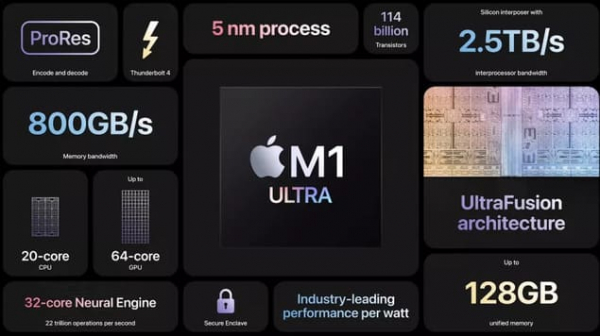

Похоже, что Apple, возможно, решила проблему с несколькими графическими процессорами, которая годами преследовала AMD и Nvidia, благодаря интерфейсу UltraFusion, представленному ранее на этой неделе, который позволяет двум чипам M1 Max работать вместе для создания одного чипа M1 Ultra.

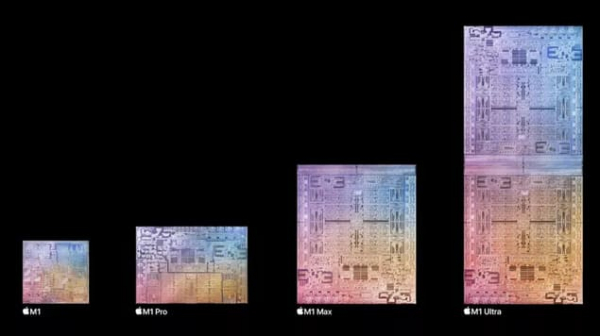

Когда Apple анонсировала M1 Max в прошлом году, компания схитрила, умолчав о том, что конструкция имеет секрет. Этот секрет был раскрыт ранее на этой неделе на мартовском мероприятии Apple, где компания рассказала, что может объединить два чипа M1 Max, превращая их в M1 Ultra с удвоенной мощностью, включая удвоение количества ядер графического процессор.

Конечно, Apple не первая компания, использующая мощность двух графических процессоров. В течение многих лет видеокарты Nvidia поддерживали SLI (Scalable Link Interface) – высокоскоростной канал связи, который позволяет одновременно подключать несколько графических процессоров для повышения производительности. У AMD была похожая технология (CrossFire), которая делает то же самое.

(Изображение представлено: Shutterstock)

| РЕШЕНИЕ ПРОБЛЕМЫ

Проблема SLI и CrossFire заключается в том, что они были недостаточно хороши, чтобы умножить мощность ПК на количество установленных графических процессоров. Таким образом, если бы у вас было две видеокарты Nvidia в режиме CLI, вы не получили бы вдвое больше производительности.

В лучшем случае это улучшение выйдет на 90%, но в большинстве случаев это улучшение не переваливает 50%, и эта производительность снижалась по мере добавления дополнительных графических процессоров. Таким образом, окупаемость инвестиций просто не стоила того, особенно если вы заплатили за три графических процессора, а получили мощность 2,5 видеокарт.

И SLI, и CrossFire также увеличивали нагрузку на ПК, особенно на ЦП, что влияло на производительность. Затем также росло и энергопотребление и, следовательно, эксплуатационные расходы и вопросы охлаждения, а также количество места, необходимое внутри корпуса и материнской платы для размещения нескольких графических процессоров.

Наконец, была проблема с приложениями, особенно с играми, которые не поддерживали или плохо поддерживали SLI и CrossFire. В некоторых случаях игра будет использовать только один графический процессор, независимо от того, сколько вы установили.

Так что, возможно, неудивительно, что CrossFire и SLI остались исключительно нишевыми, и вы не услышите, чтобы AMD или Nvidia обсуждали их. Фактически, несколько лет назад Nvidia фактически отказалась от SLI в пользу NVLink для видеокарт RTX. Однако цена и тот факт, что достаточно сложно купить один графический процессор Nvidia, не говоря уже о нескольких графических процессорах, привели к тому, что эта технология осталась нелюбима.

(Изображение предоставлено: Apple)

Однако с M1 Ultra Apple, похоже, решила большинство проблем. Во-первых, соединение UltraFusion было разработано для обеспечения чрезвычайно низкой задержки (по сути, задержки при передаче данных, чем она меньше, тем лучше) между двумя чипами M1 Max – с пропускной способностью 2,5 Тб/с. Это невероятно быстро и гораздо лучше, чем когда-либо предполагали SLI или CrossFire.

Скорость UltraFusion дает множество преимуществ, наиболее очевидным из которых является производительность, поэтому Apple с уверенностью заявляет, что M1 Ultra обеспечит вдвое большую производительность, нежели M1 Max.

Превращая два M1 Max в один чип M1 Ultra, Apple также избежала снижения производительности, с которым обычно сталкиваются установки с несколькими графическими процессорами. И пока M1 Ultra становится самым большим чипом, который Apple когда-либо выпускала, тем временем он меньше физических дискретных видеокарт, что позволяет использовать его внутри Mac Studio, о котором также было заявлено на мероприятии во вторник.

Семейство чипов M1 также получило признание за их производительность на ватт, поскольку они гораздо более энергоэффективны, нежели конкурирующие предложения. Это позволяет MacBook с чипами M1 имеет более продолжительное время автономной работы, сохраняя при этом охлаждение даже под большой нагрузкой, M1 Ultra продолжает тенденцию. По данным Apple, графический процессор M1 Ultra предлагает лучшую производительность, чем предлагает RTX 3090 от Nvidia, при этом потребляя на 200 Вт меньше энергии.

(Изображение предоставлено: Apple)

Это, безусловно, смелое заявление, но в наши дни растущих цен на энергию энергоэффективность наших компонентов становится важным фактором. Ходят слухи, что следующее поколение графических процессоров Nvidia, таких как RTX 4080, станет более энергоемким, что может сделать подход Apple гораздо более привлекательным.

Наконец, похоже, что подход Apple принесет свои плоды и в отношении поддержки программного обеспечения. Приложения будут видеть M1 Ultra как единый чип, а это значит, что дополнительного кодирования не потребуется – поддержка приходит «из коробки», что позволит приложениям использовать дополнительную производительность. Это главная особенность, которая способна изменить правила игры.

Заговаривая об этом, несмотря на то, что Mac традиционно не считается игровым компьютером, именно игры будут рассматривать M1 Ultra как единственный чип, предоставляющий дополнительную мощность. Учитывая, что M1 Ultra явно превосходит RTX 3090, могла ли Apple создать фантастический игровой графический процессор?

Нам придется подождать, чтобы проверить заявления Apple самостоятельно, но сейчас всё звучит многообещающе. Победа Apple на этом направлении может подтолкнуть Nvidia и AMD к переоценке своей технологии с несколькими графическими процессорами, что может привести к ещё более впечатляющей производительности в играх и профессиональном назначении. Мы не можем дождаться.

Вот лучшие видеокарты 2022 года.